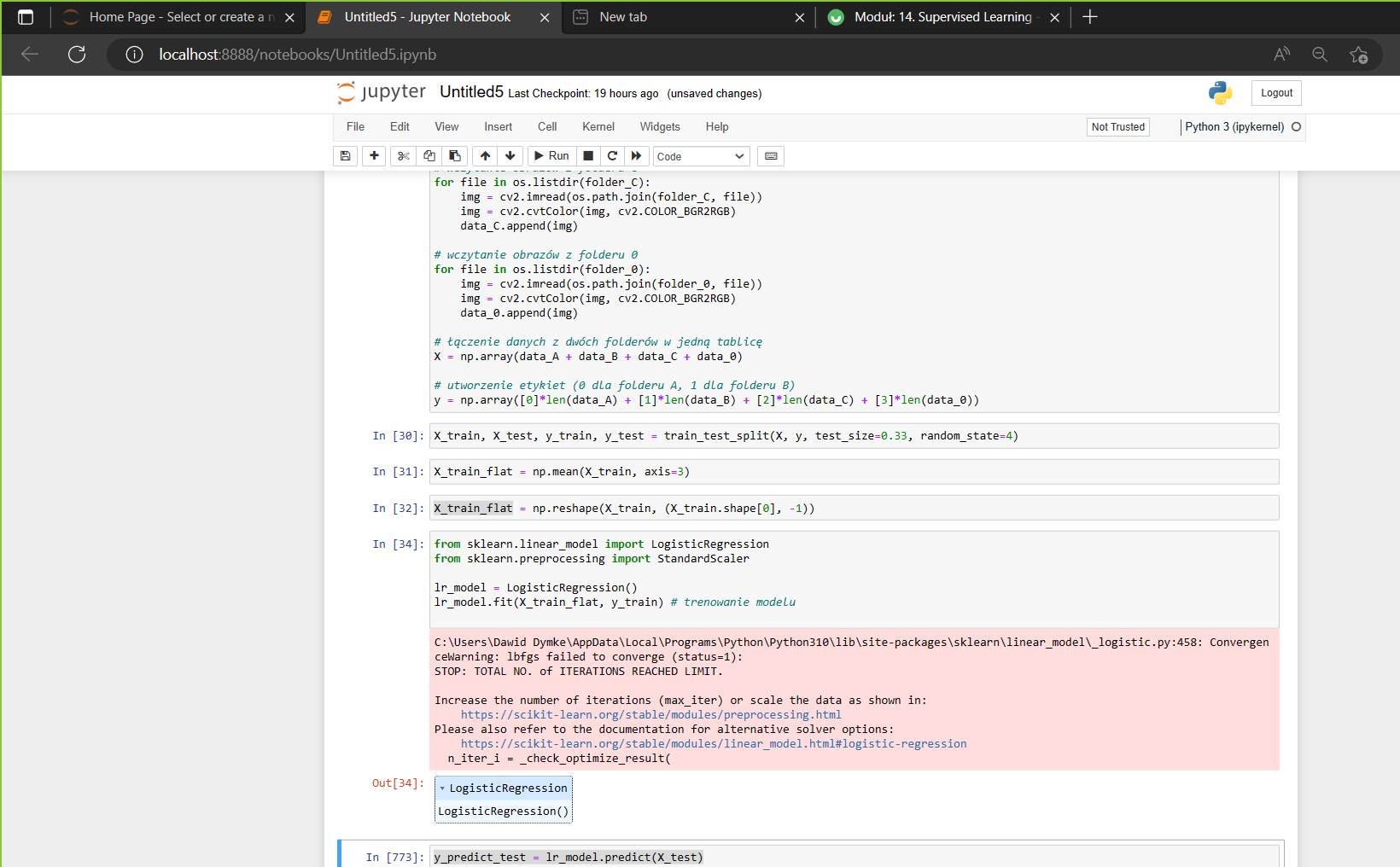

Jestem w trakcie pisania kodu odnośnie sieci neuronowych , program pracuje na 1200 zdjęciach na których są robione dane testowe , treningowe , walidacyjne itp. , poniżej jest link do mojego githuba , gdzie można sobie zobaczyć mój kod :

Działam na keras , tensorflow

https://github.com/dawid584/sign-language/blob/master/Untitled5.ipynb

Natomiast nie wiem jak zrobić jak w tytule podane metryki ?

W internecie jest napisane np. coś takiego -

tf.keras.metrics.Accuracy(name="accuracy", dtype=None) a potem

m = tf.keras.metrics.Accuracy() m.update_state([[1], [2], [3], [4]], [[0], [2], [3], [4]])

m.result().numpy() 0.75

Tylko , ja nie wiem co mam wprowadzić zamiast 1], [2], [3], [4, 0], [2], [3], [4 bo u mnie to są dane :

train_size = int(np.floor(0.8 * size)) a size to rozmiar zbioru załądownych plików zdjęć .

valid_size = int(np.floor(0.1 * size))

test_size = size - train_size - valid_size

Jak przygotować dane by móc je wprowadzić do metryki i zrobić podane metryki ? To mają być dane treningowe i testowe i potem X_pred i y_pred ? Bo z podanego modelu który jest na moim githubie to nie wiem jak to zrobić ?