Z tego, co wiem, SEO to są działania w dwóch aspektach:

-

Dopracowanie pozycjonowanej strony pod kątem jakości kodu, właściwego doboru tytułów i treści, tworzenie treści czytelnej dla wyszukiwarek, unikanie treści ukrytej lub mającej zmylić wyszukiwarkę (wyszukiwarka Google od dawna potrafi wyczuć istnienie takich treści), pliki robots.txt i sitemap.xml, o ile jest to potrzebne. W tym aspekcie autor strony ma pełny wpływ na pozycję, a modyfikacje i testowanie mogą być wykonywane offline.

-

Dobór odpowiedniego adresu domenowego, spowodowanie istnienia linków przekierowujących na pozycjonowaną stronę z odpowiednich źródeł, w odpowiedniej ilości, umieszczenie pozycjonowanej strony w reklamach i katalogach. W tym aspekcie autor nie ma pełnego wpływu, nie jest możliwe wykonanie pożądanych działań w krótkim czasie, istotną rolę odgrywa URL strony, a Google bada nie samą stronę, tylko jej, jakby to powiedzieć, otoczenie internetowe.

Jak łatwo się domyślić, pierwszy aspekt jest związany z samą aplikacją, można go realizować jeszcze niezależnie od istnienia jej w internecie, natomiast drugi aspekt dotyczy już nie aplikacji, tylko właśnie jej "otoczenia internetowego", które też ma wpływ na pozycje w wyszukiwarce.

Ponieważ Google dobiera kolejność pozycji na SERP badając dana stronę między innymi w pierwszym aspekcie, a więc w tym, na który ma się największy wpływ i można go realizować niezależnie od internetu, można przyjąć, że google bada stronę wg jakiegoś algorytmu i ją punktuje, np. dobrze dopracowanej treści z umiarkowaną gęstością słów kluczowych podnosi wynik, dobrze zrobiona nawigacja podnosi wynika, biały tekst na białym tle znacznie obniża punktację, a słowa kluczowe w meta tagu "keywords" nie mają żadnego wpływu na punktację (Google nie bierze tego pod uwagę ze względu na nadużycia i manipulacje w przeszłości). Można powiedzieć, że istnieje algorytm, w którym na wejściu jest adres aplikacji (badaniu podlega to, co wychodzi z serwera HTTP, a nie kod samej aplikacji) i słowa wyszukiwania (bo SEO zawsze jest pod określone słowa i frazy), a na wyjściu jest wynik oceny treści, że im wyższy wynik, tym łatwiej osiągnąć wyższa pozycję w SERP (oczywiście na pozycję wpływa też drugi aspekt, ale nie o tym jest ten temat).

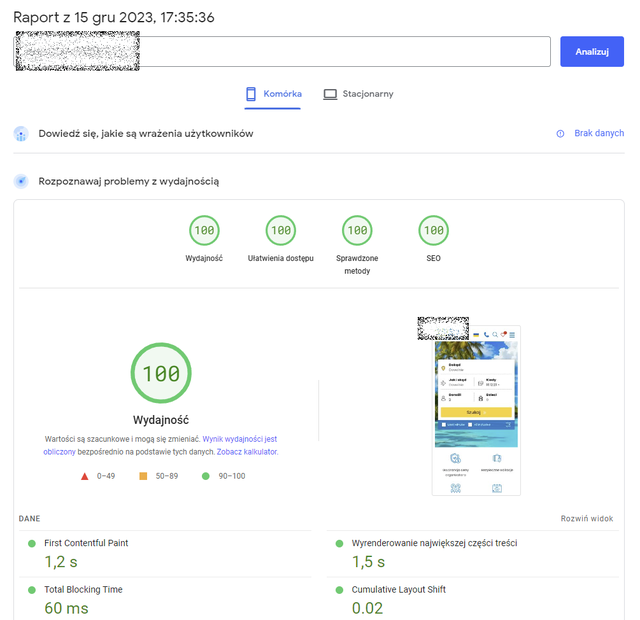

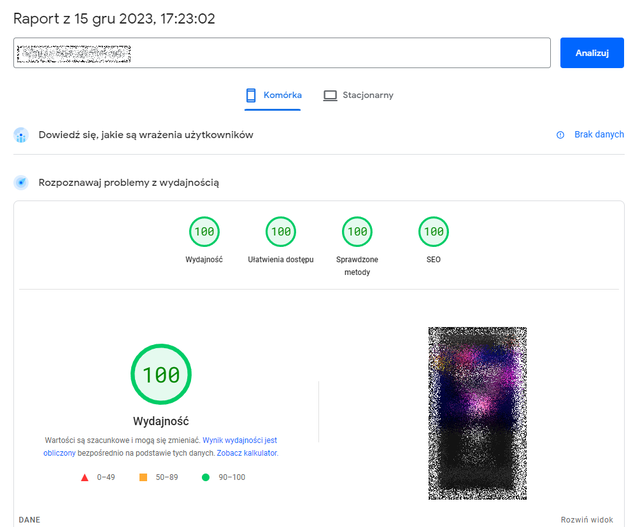

Pytanie jest proste i następujące: Nawet, jeżeli sam algorytm oceniający stronę stosowany przez Google jest tajny i często zmieniany, to jak nazywa się i jak skorzystać z narzędzia Google, które na wskazanej przeze mnie stronie odpala ten sam algorytm (aspekt nr 1) i podaje wynik oceny plus ewentualnie informacje, co na nią wpływa i co wypadałoby poprawić, aby uzyskać lepszą ocenę?

Chodzi o prostą rzecz: Wpisuję adres (może być adres IP, może być darmowa domena, bo w aspekcie nr 1 nie ocenia się adresu, tylko sam kod strony), wpisuję słowa, pod które chcę wypozycjonować, a otrzymuję informację, typu "Strona otrzymuje 354 punktów, treść jest skopiowana ze strony XYZ, istnieje biały tekst na białym tle". Usuwam biały tekst na białym tle i już jest 1456 punktów. Przeredaguję treść, żeby nie było plagiatu i już jest 1800 punktów. W ten właśnie sposób mógłbym dowolnie zmieniać treść tak, jak mi pasuje i uruchamiać ocenę SEO po każdej zmianie, dążąc do możliwie najwyższego wyniku punktowego. Za pomocą takiego narzędzia można by dopracować stronę w stosunkowo krótkim czasie, a dopracowanie jest bardzo pożądane przez Google i "nagradzane" wyższa pozycją w SERP.

Nie pisze tu o aspekcie nr 2, ponieważ ja nie mam pełnego wpływu na niego, jest on trudny w realizacji, czasochłonny w realizacji, to nie jest kwestia jednej czy dwóch modyfikacji w krótkim czasie, czym odróżnia się od aspektu nr 1.