Banał, jednak musisz wiedzieć, że to zwykła kradzież lub przynajmniej działanie na szkodę. Zanim jednak się coś zacznie warto poczytać a przede wszystkim pomyśleć.

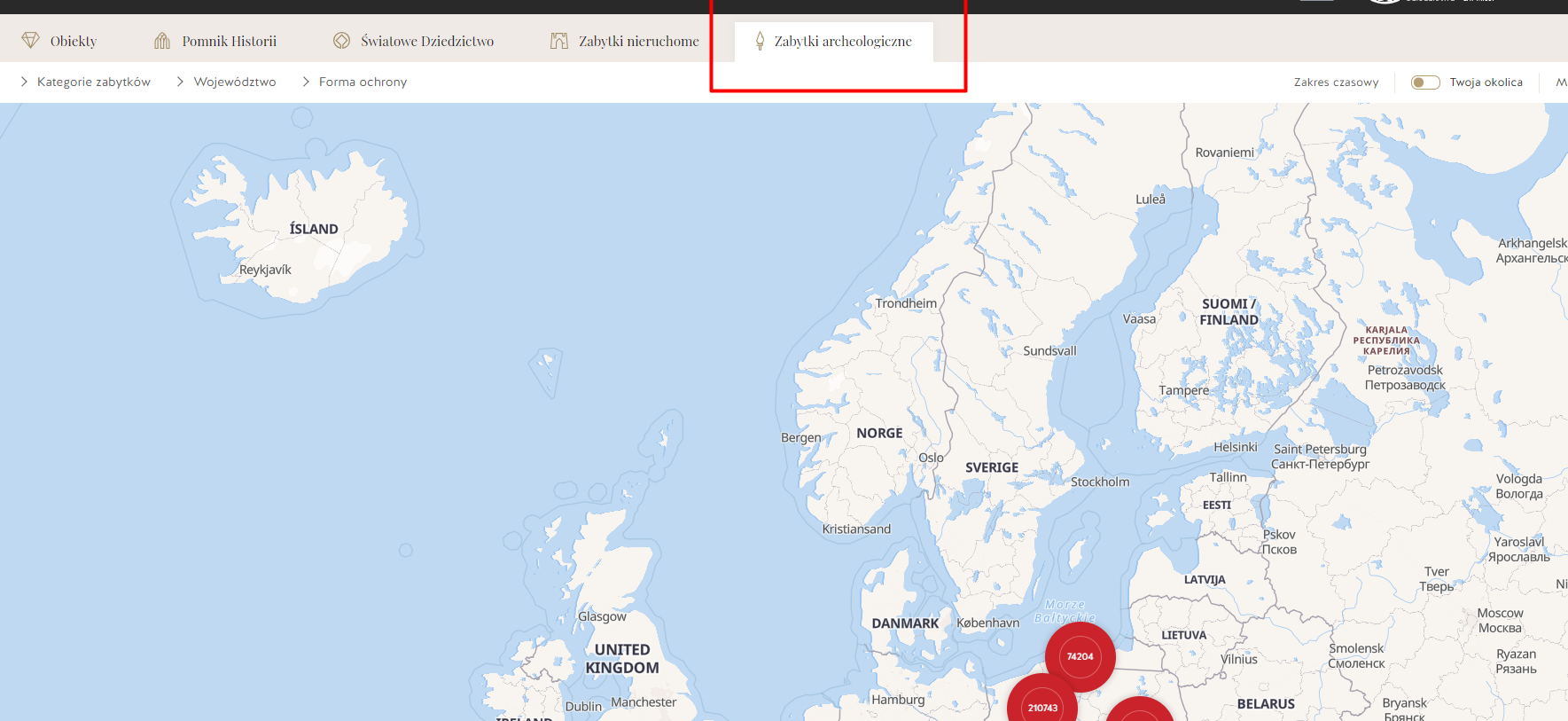

W bazie mamy ponad 600 000 obiektów każda strona ma osadzone obrazki więc trzeba przeciągnąć do siebie: 286GB danych HTML do dalszego parsowania. Myślę, że jak się z nimi skontaktujesz zapłacisz i wniesiesz jakąś symboliczną opłatę to może dostaniesz tą bazę bez robienia z siebie złodzieja.

Poza tym to są dane publiczne i tu masz punkt zaczepienia:

Gdyby jednak jakiś osioł chciał to scrapować to żeby pobrać całą bazę wystarczy kilka linijek kodu w PHP (o ile nas nie zablokują).

$data = file_get_contents ( 'https://zabytek.pl/pl/api/map/markers?all=1&version=2023-11-12%2004:30:01' );

file_put_contents ( 'points.json', $data );

$dataArr = json_decode ( $data, true );

forEach ( $dataArr as $itm ){

$id = $itm[0];

$infoDat = file_get_contents( "https://zabytek.pl/pl/api/map/marker/{$id}" );

file_put_contents ( "info_{$id}.json", $infoDat ) ;

$pageUrl = "https://zabytek.pl".json_decode ( $infoDat, true )['url'];

$pageContent = file_get_contents( $pageUrl );

file_put_contents ( "page_{$id}.html", $pageContent ) ;

sleep(1); // można mniejszy czas albo jakieś odpytywanie równoległe...

}

Uwaga: file_put_contents musi obsługiwać CURL.

A tu już wersja na "wypasie" z licznikiem :-)

<?php

@mkdir ( 'point_info' ); @mkdir ( 'point_web' );

if ( !file_exists( 'points.json' ) ){

$data = file_get_contents ( 'https://zabytek.pl/pl/api/map/markers?all=1&version=2023-11-12%2004:30:01' );

file_put_contents ( 'points.json', $data );

} else $data = file_get_contents('points.json');

$dataArr = json_decode ( $data, true );

$count = count($dataArr) ;

$ii = 0;

forEach ( $dataArr as $itm ){

$id = $itm[0];

$infoDat = file_get_contents( "https://zabytek.pl/pl/api/map/marker/{$id}" );

file_put_contents ( "point_info/info_{$id}.json", $infoDat ) ;

$pageUrl = "https://zabytek.pl".json_decode ( $infoDat, true )['url'];

$pageContent = file_get_contents( $pageUrl );

file_put_contents ( "point_web/page_{$id}.html", $pageContent ) ;

$ii++;

echo ( "Wykonano: {$ii} z {$count}\r\n" );

}