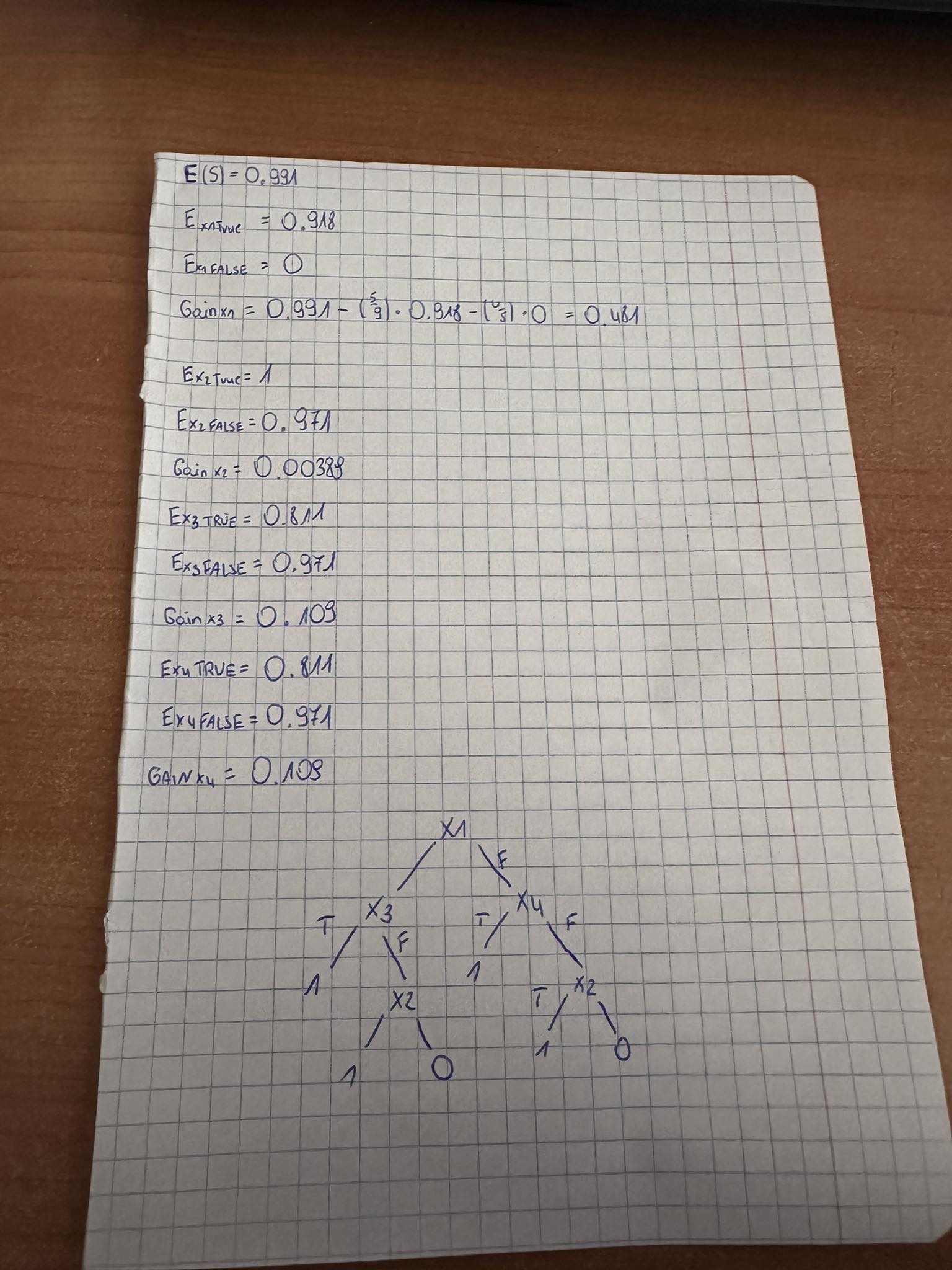

Witam, otóż mam problem z zadaniem które odnosi się do drzewa dycyzyjnego oraz algorytmu ID3. W poleceniu jest napisane, że nie mam liczyć entropii natomiast nie mam zielonego pojęcia jak zrobić to w inny sposób. Mój aktualny poziom rozwiązania zadania jest na zdjęciu

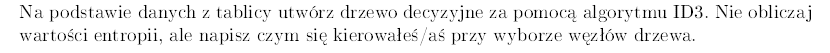

Polecenie do zadania oraz tabelka do niego:

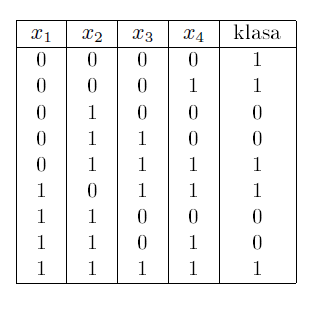

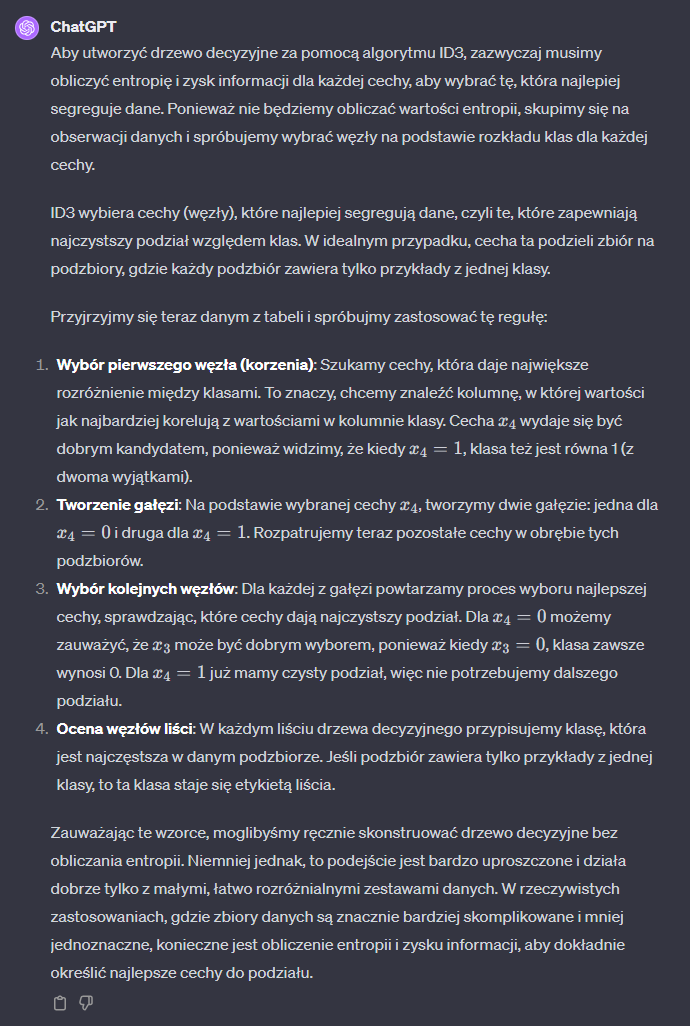

Takie coś mi wygenerował ChatGPT:

Tutaj opis:

Drzewo działa w ten sposób,

Wybieramy warunek np. x < 10 i dajemy wartości na lewo, a większe na prawo.

Potem liczymy entropię dla danej gałęzi i tak jak wszystkie wartości są jednego typu to mamy niską entropię, a jak są różnego typu to wysoką.

Jak masz 0% szans w lewo, 0% w prawo i 0% do przodu, 100% do tyłu to masz niską entropię, a jak 25%, 25%,25% i 25% w każdym kierunku to wysoką czyli losowość i brak zdecydowania.

Sumujemy entropię między gałęziami i mamy information gain.

Przy generowaniu drzewa próbujemy znaleźć taki warunek co daje duży information gain.

Czyli zwykle wielokrotnie się losuje dane, ale też analitycznie da się to zrobić, chodź losowanie czy jakiś gaussian process się nada, chodź te ostatnie to chyba armata do takiego zadania.

Analogia do entropii to może być powiedzmy policzenie ile jest danych elementów tego samego rodzaju i próba zmaksymalizowania ich.

Np. jak twój warunek x < 10, zakwalifikował 3 elementy jako puszka i 1 jako butelka, to teoretycznie masz niższą entropię niż 2 puszka i 2 butelka.

Więc bez entropii mógłbyś np. zliczać ilość elementów i jak jest dużo tego samego typu to stwierdzać jako dobry warunek w drzewie decyzyjnym.

W drzewie decyzyjnym chodzi o to, żeby ładnie rozróżnić jedną rzecz od drugiej na podstawie jakichś cech.

Wiele takich drzew to potem jest forest i tam się stosuje bootstraping features, czyli takiego kopiowania cech sztucznie.

Dobrze, że studiujesz matmę, bo to jedyna rzecz, której zrozumienie daje nieograniczone szczęście.

Z ciekawych filmów to na youtube to

W miarę dobrze jest wytłumaczone działanie.

A tak zamiast entropii to jakąś średnią wystąpień mógłbyś policzyć i było by to samo co entropia.